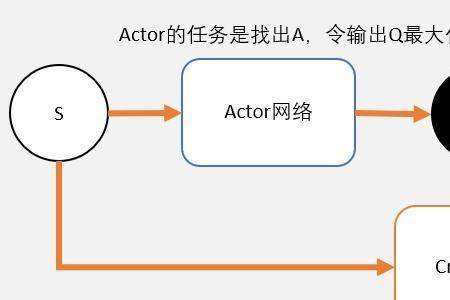

ddpg算法优点:是sample efficiency,DDPG的actor crtic均可以off-policy,而gradient estimator由于deterministic policy也确实是无偏的,是可以continuous control。DPG的actor是通过SGD去解max-Q的(而不是遍历),所以也能做continuous control。

缺点:第一点是deterministic policy,意味着不能很好的explore state Action space。

原创 | 2022-12-04 17:52:47 |浏览:1.6万

ddpg算法优点:是sample efficiency,DDPG的actor crtic均可以off-policy,而gradient estimator由于deterministic policy也确实是无偏的,是可以continuous control。DPG的actor是通过SGD去解max-Q的(而不是遍历),所以也能做continuous control。

缺点:第一点是deterministic policy,意味着不能很好的explore state Action space。

Copyright 2005-2020 www.kxting.com 版权所有 |  湘ICP备2023022655号

湘ICP备2023022655号

声明: 本站所有内容均只可用于学习参考,信息与图片素材来源于互联网,如内容侵权与违规,请与本站联系,将在三个工作日内处理,联系邮箱:47085,1089@qq.com