不是。

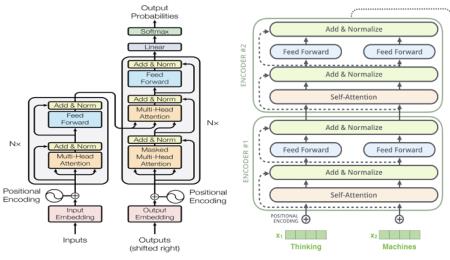

BERT模型(Bidirectional Encoder Representation from Transformers)是谷歌AI团队发布于2018年10月的BERT预训练模型,被认为是 NLP 领域的极大突破,刷新了11个NLP任务的当前最优结果。 其对GPT语言模型做了进一步的改进,通过左、右两侧上下文来预测当前词和通过当前句子预测下一个句子,预训练的 BERT 表征可以仅用一个额外的输出层进行微调,在不对任务特定架构做出大量修改条件下,就可以为很多任务创建当前最优模型。

原创 | 2022-11-30 18:17:30 |浏览:1.6万

不是。

BERT模型(Bidirectional Encoder Representation from Transformers)是谷歌AI团队发布于2018年10月的BERT预训练模型,被认为是 NLP 领域的极大突破,刷新了11个NLP任务的当前最优结果。 其对GPT语言模型做了进一步的改进,通过左、右两侧上下文来预测当前词和通过当前句子预测下一个句子,预训练的 BERT 表征可以仅用一个额外的输出层进行微调,在不对任务特定架构做出大量修改条件下,就可以为很多任务创建当前最优模型。

Copyright 2005-2020 www.kxting.com 版权所有 |  湘ICP备2023022655号

湘ICP备2023022655号

声明: 本站所有内容均只可用于学习参考,信息与图片素材来源于互联网,如内容侵权与违规,请与本站联系,将在三个工作日内处理,联系邮箱:47085,1089@qq.com